如何配置应用模型

Alaya Studio平台作为代理开发平台,需要在开始使用前进行一系列模型的配置。具体包括:

1.大语言模型(LLM):生成式大语言模型。

2.向量化模型:将文本转换为空间向量。

3.文件解析模型:用于解析和理解各种格式的文本内容。

4.多模态模型:能够处理和分析多种类型的数据,如图像、视频和音频。

配置这些模型后,Alaya Studio 平台将能够整合它们的能力,提供强大的Agent功能。接下来,我将详细介绍如何配置这些模型。

Inference部署大语言模型

1.登录系统之后,进入Inference应用(开通之后) ;点击 模型仓库进入模型服务界面

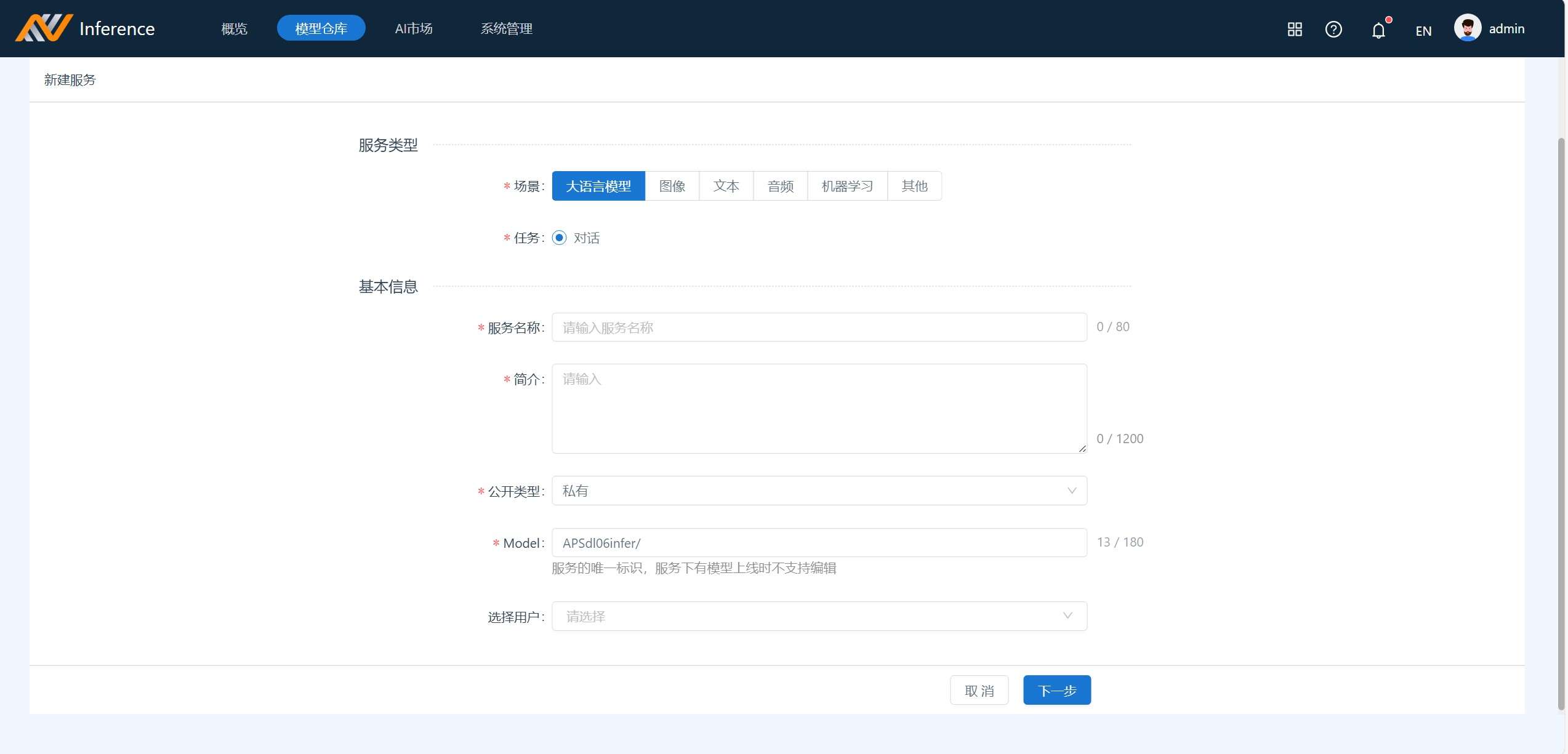

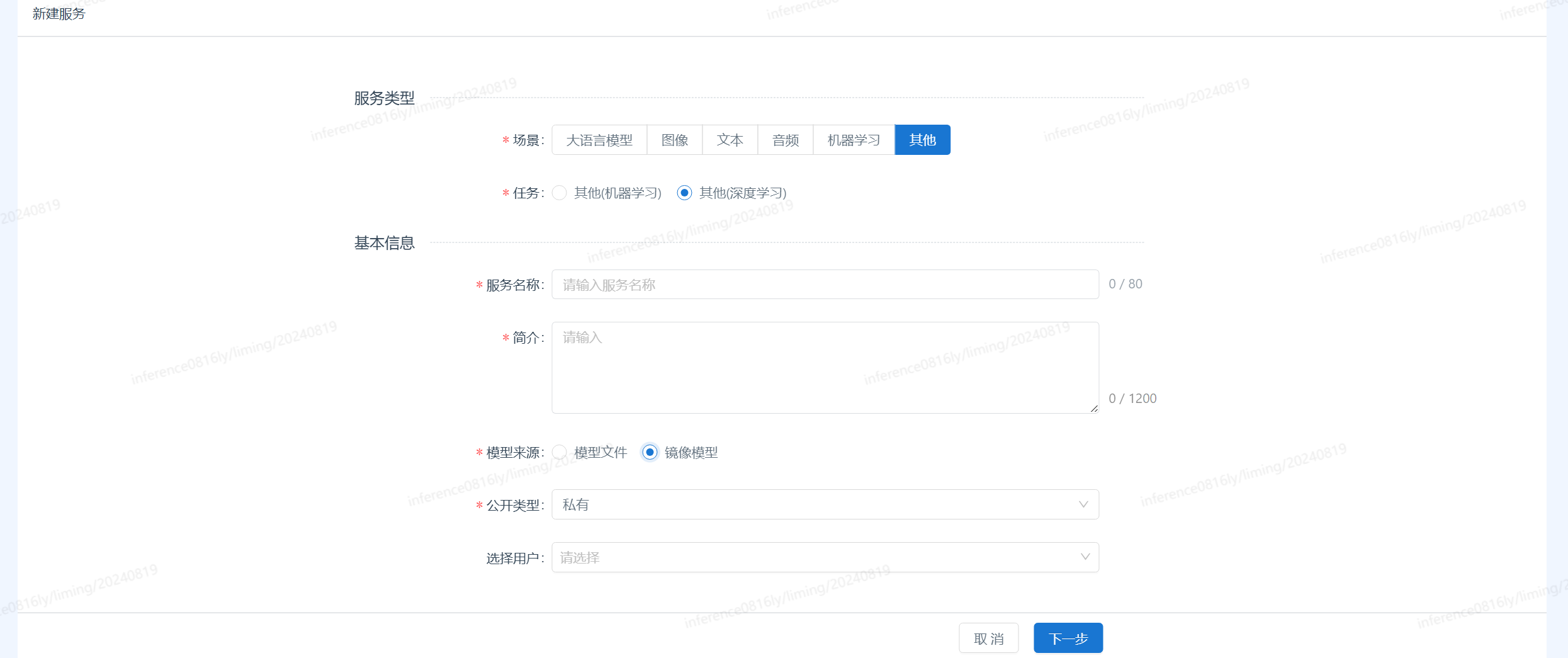

点击右上角的新建服务,进入界面后:场景选择大语言模型,服务名称、简介、公开类型按照自己的需求进行填写

2.创建完成的Inference的服务之后,进入创建的服务,点击左侧菜单中的

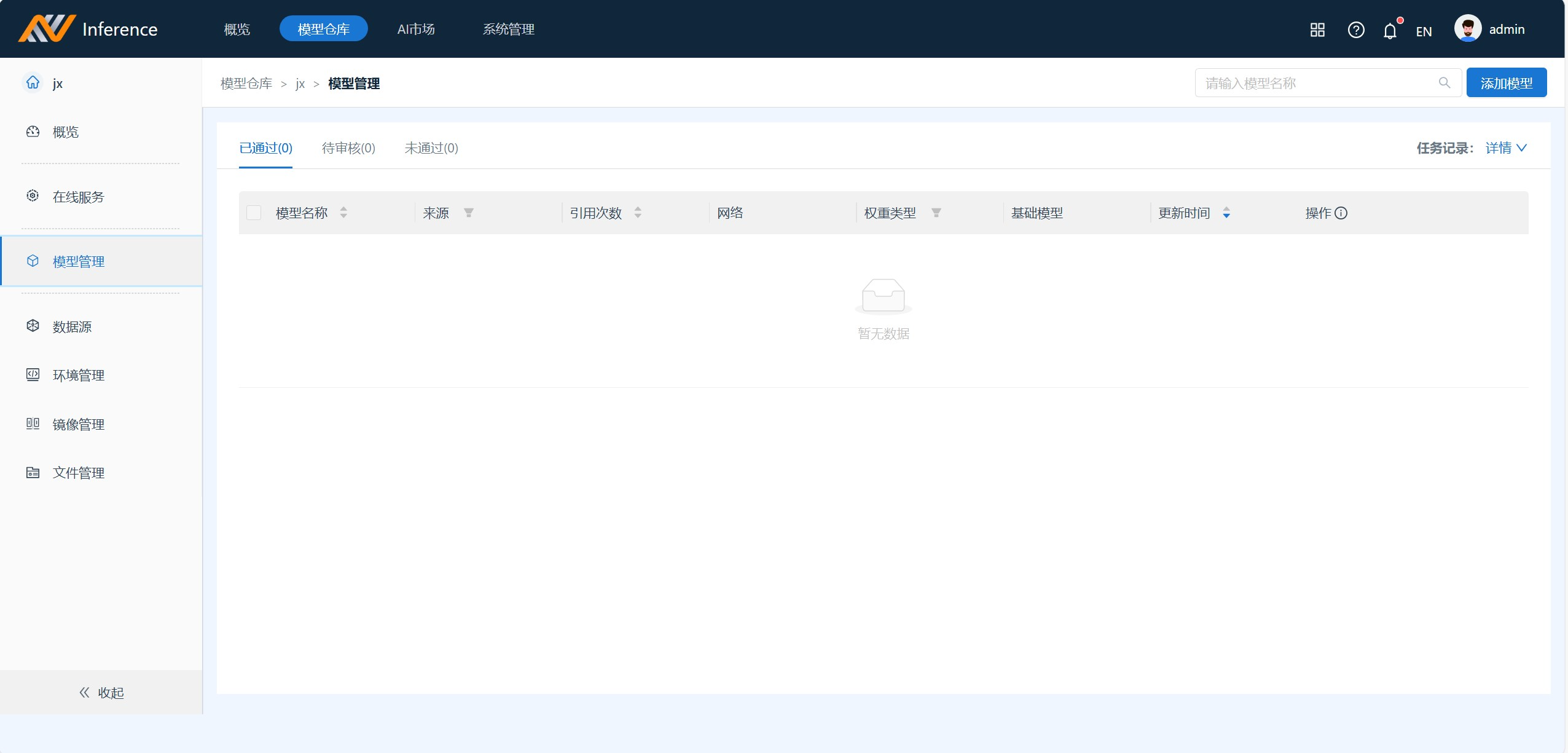

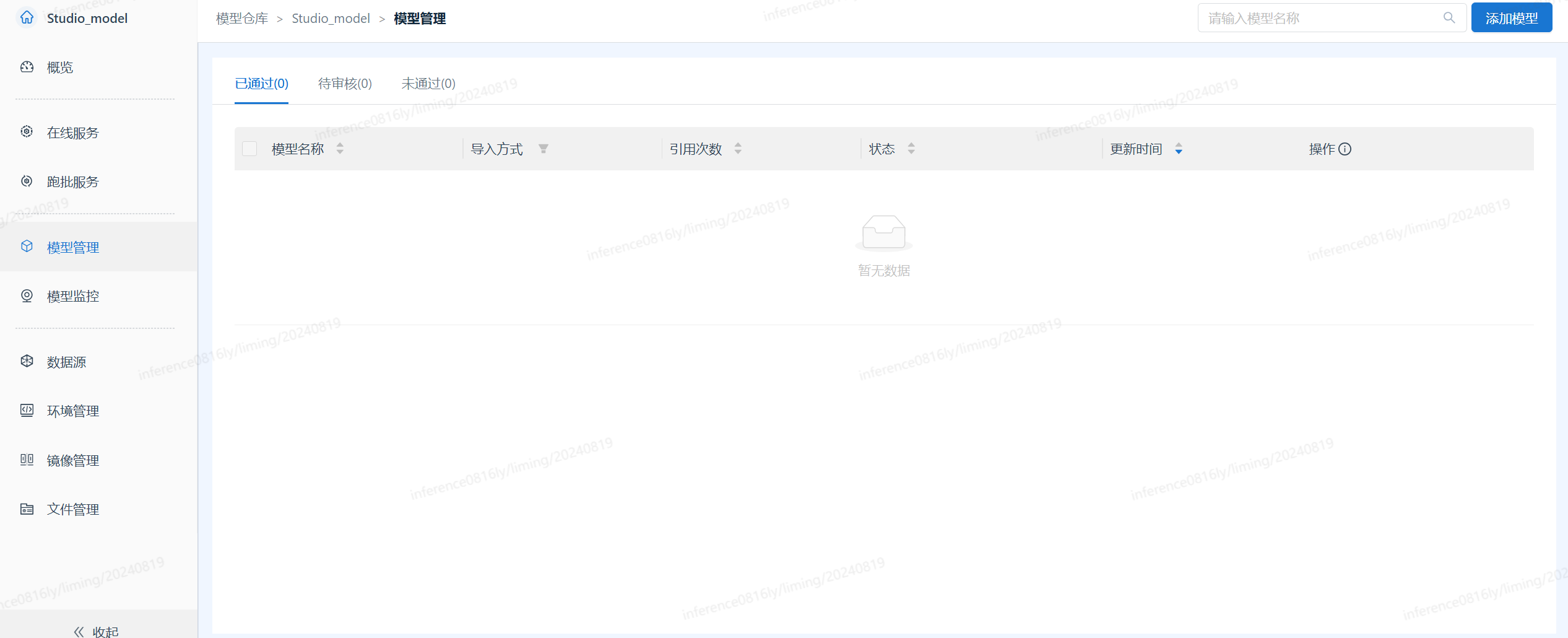

2.创建完成的Inference的服务之后,进入创建的服务,点击左侧菜单中的模型管理

3.点击模型管理界面的

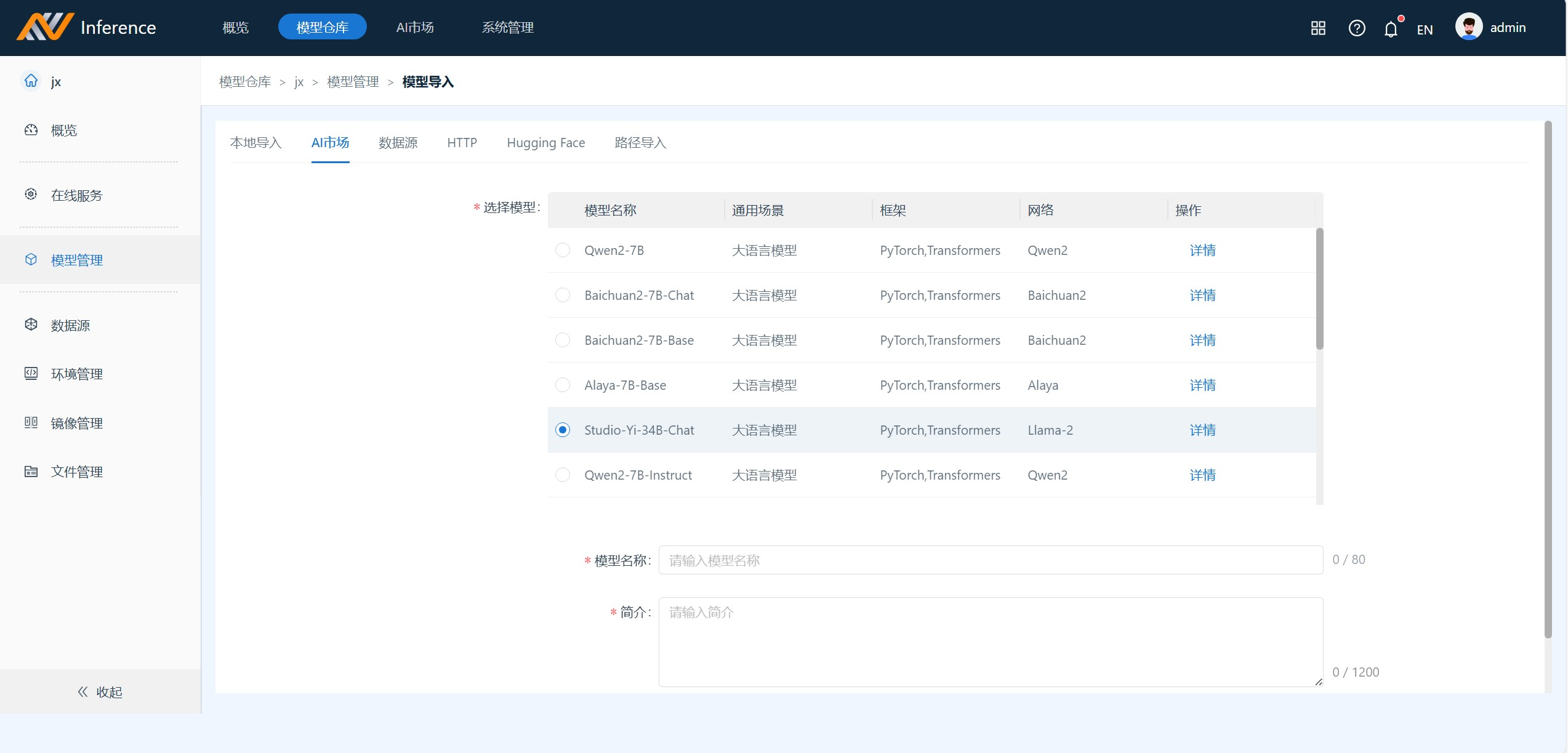

3.点击模型管理界面的添加模型 选择AI市场选择 “Studio-Yi-34B-Chat” 填写 模型名称 、简介,点击提交。

4.添加模型完毕之后,然后点击右侧的

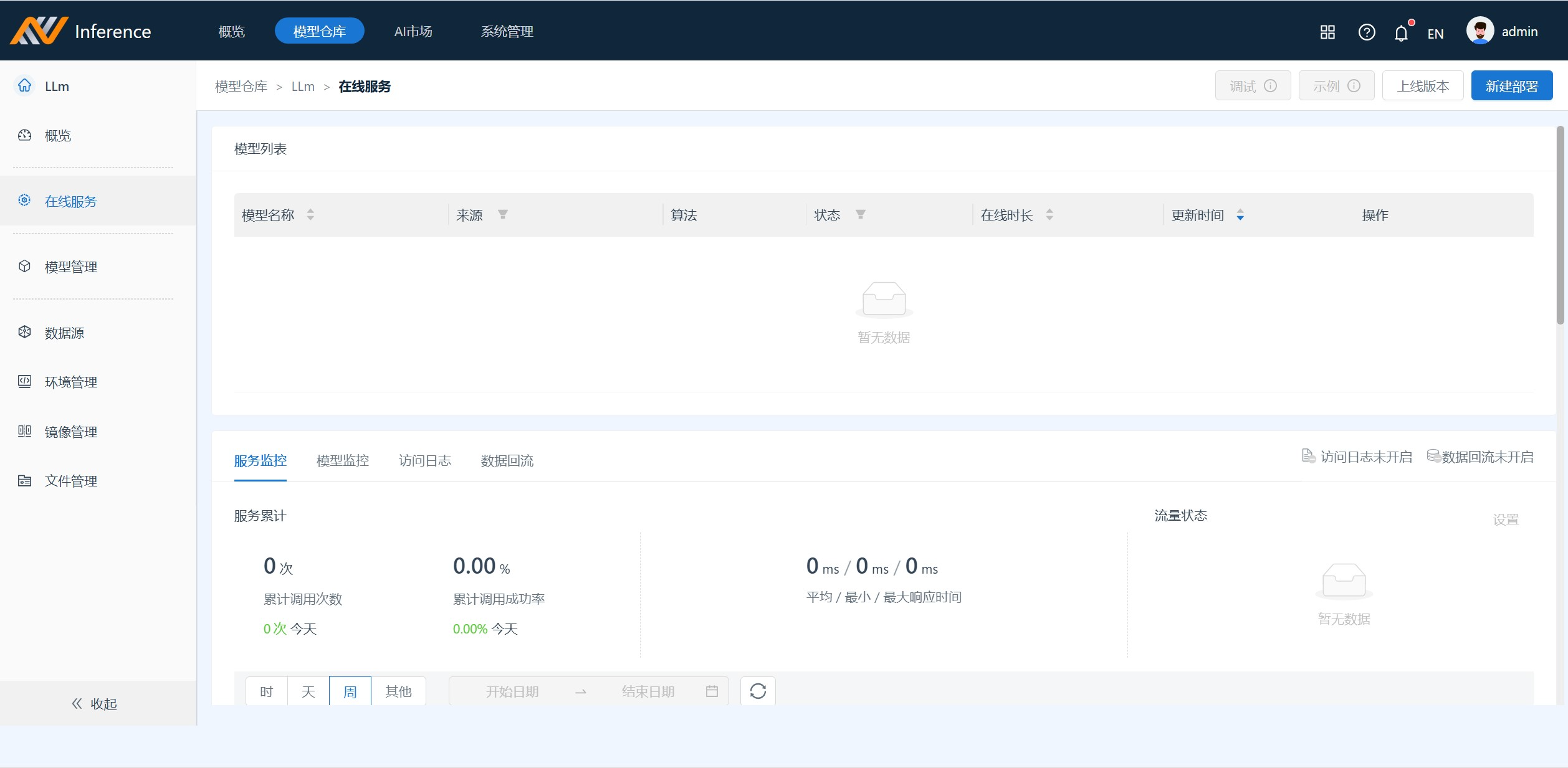

4.添加模型完毕之后,然后点击右侧的在线服务,进入在线服务界面,点击新建部署,选择刚才在模型管理配置的模型;模型部署完毕后,选择模型上线

5.模型上线成功后,进入

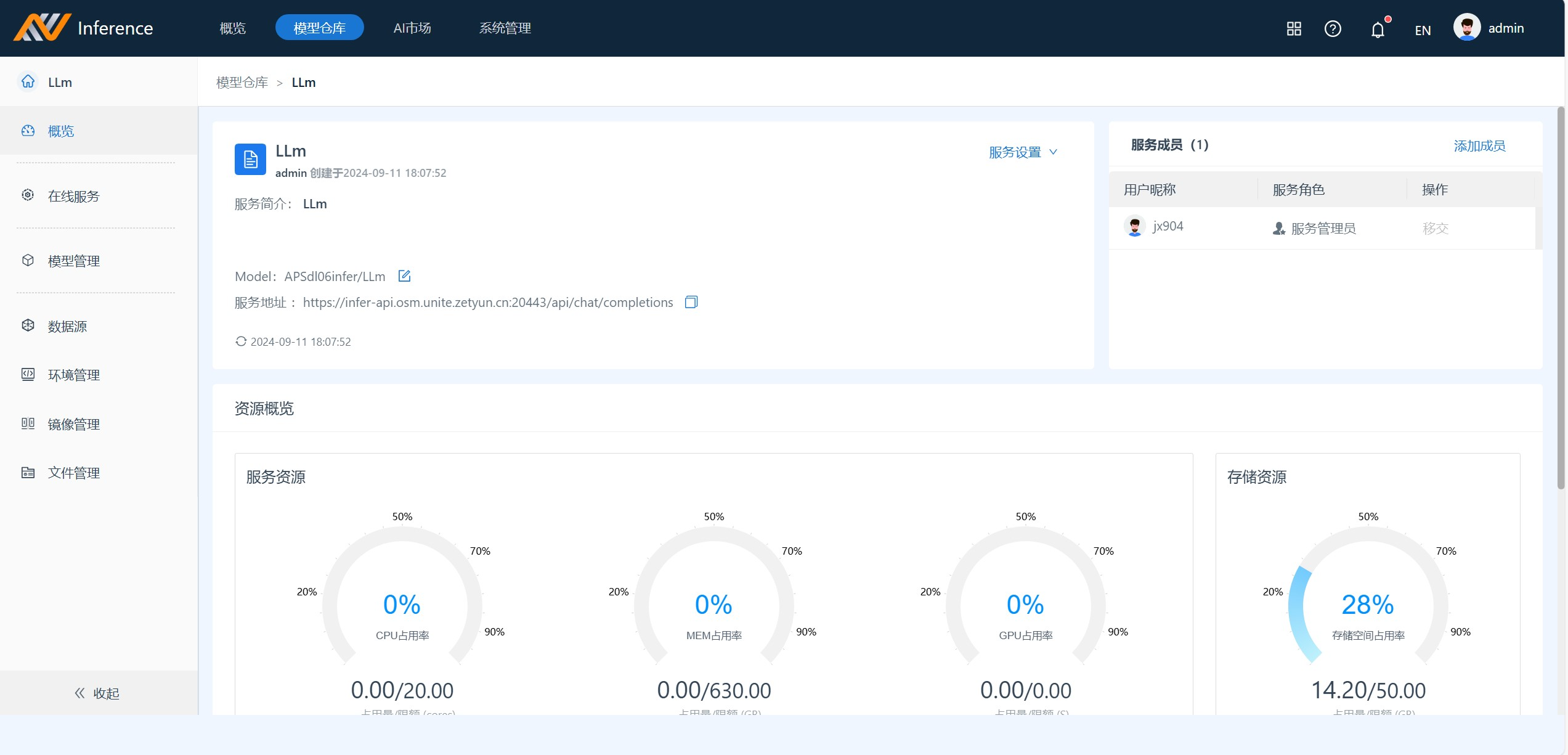

5.模型上线成功后,进入概览界面复制Model``服务地址

Alaya Studio配置大语言模型

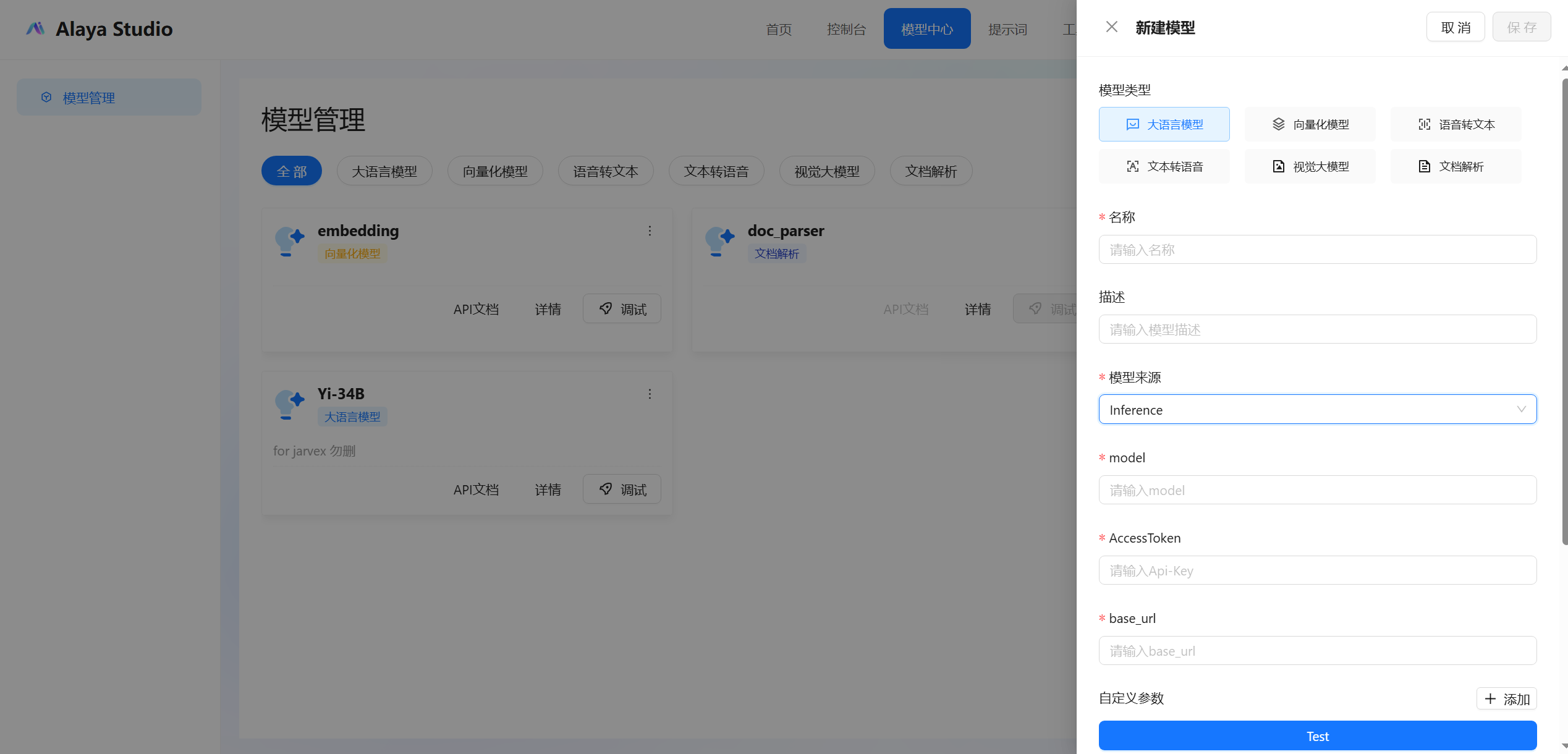

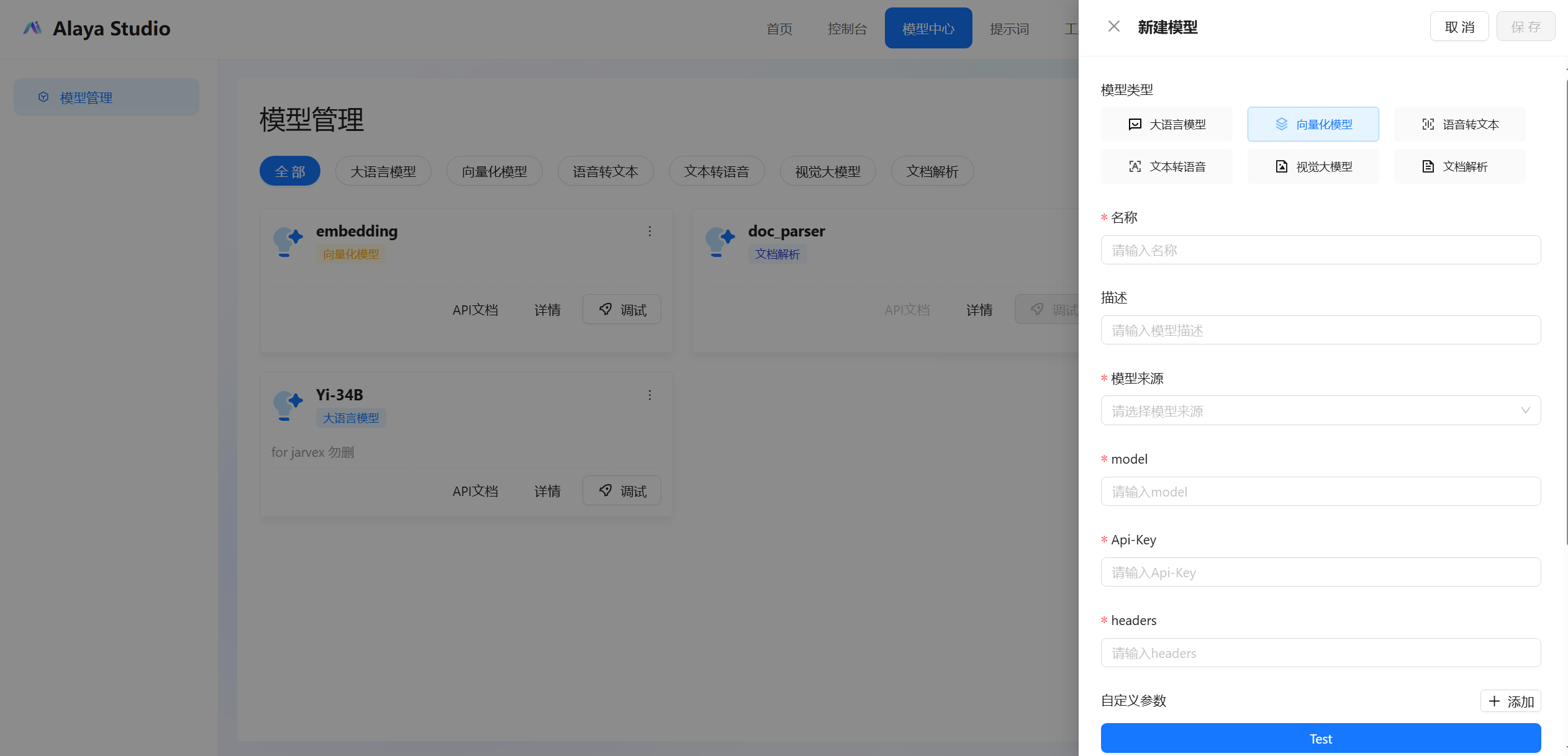

1.通过Alaya NeW 中的Studio入口进入Alaya Studio系统,点击模型中心中的新建,选择大语言模型

2.

2.名称按照自己需求填写,在模型来源选项中选择“inference”。将Inference项目中复制的模型和服务地址分别填写到对应的Model和base_url输入框中,同时填写您自行创建的AssToken。

完成所有必填项后,点击Test按钮进行测试。测试成功后,请点击页面右上角的保存按钮;

随后,模型中心中出现创建的新模型,可以在控制台对模型进行调试,并可以对外提供API服务。 部署使用模型镜像

Inference部署镜像模型

1.登录系统之后,进入Inference应用(开通之后) ;点击 模型仓库进入模型服务界面

点击右上角的新建服务,进入界面后:场景选择其他,任务选择其他深度学习,模型来源选择镜像模型,服务名称、简介、公开类型按照自己的需求进行填写

2.创建完成的Inference的服务之后,进入创建的服务,点击左侧菜单中的

2.创建完成的Inference的服务之后,进入创建的服务,点击左侧菜单中的模型管理

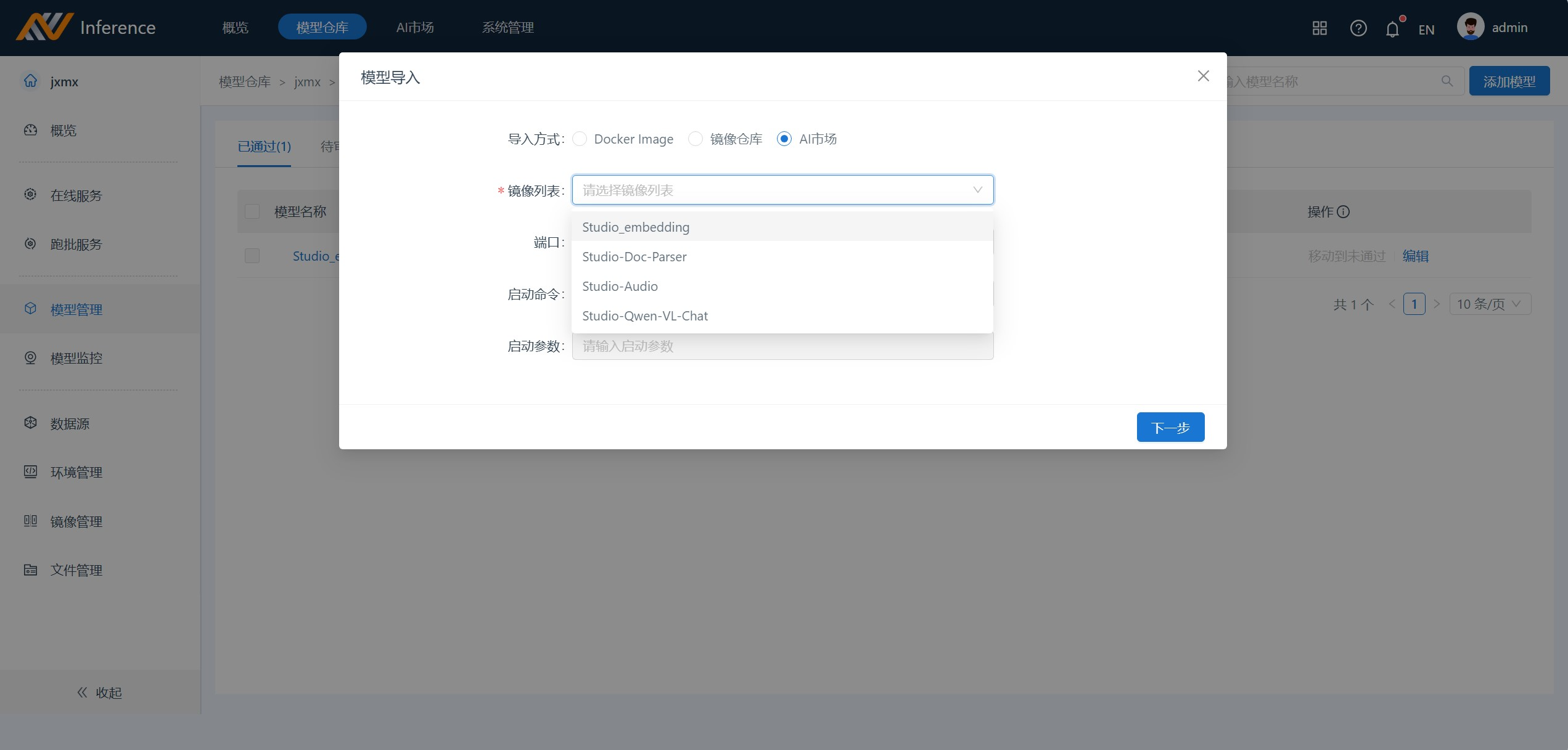

3.点击模型管理界面的

3.点击模型管理界面的添加模型,选择AI市场,在镜像列表中选择需要的模型:

Studio_embedding: 向量化模型

Studio-Qwen-VL-chat:多模态的模型

Studio-Doc-Parser :文件解析模型

Studio-Audio:语音转文本、文本转语音

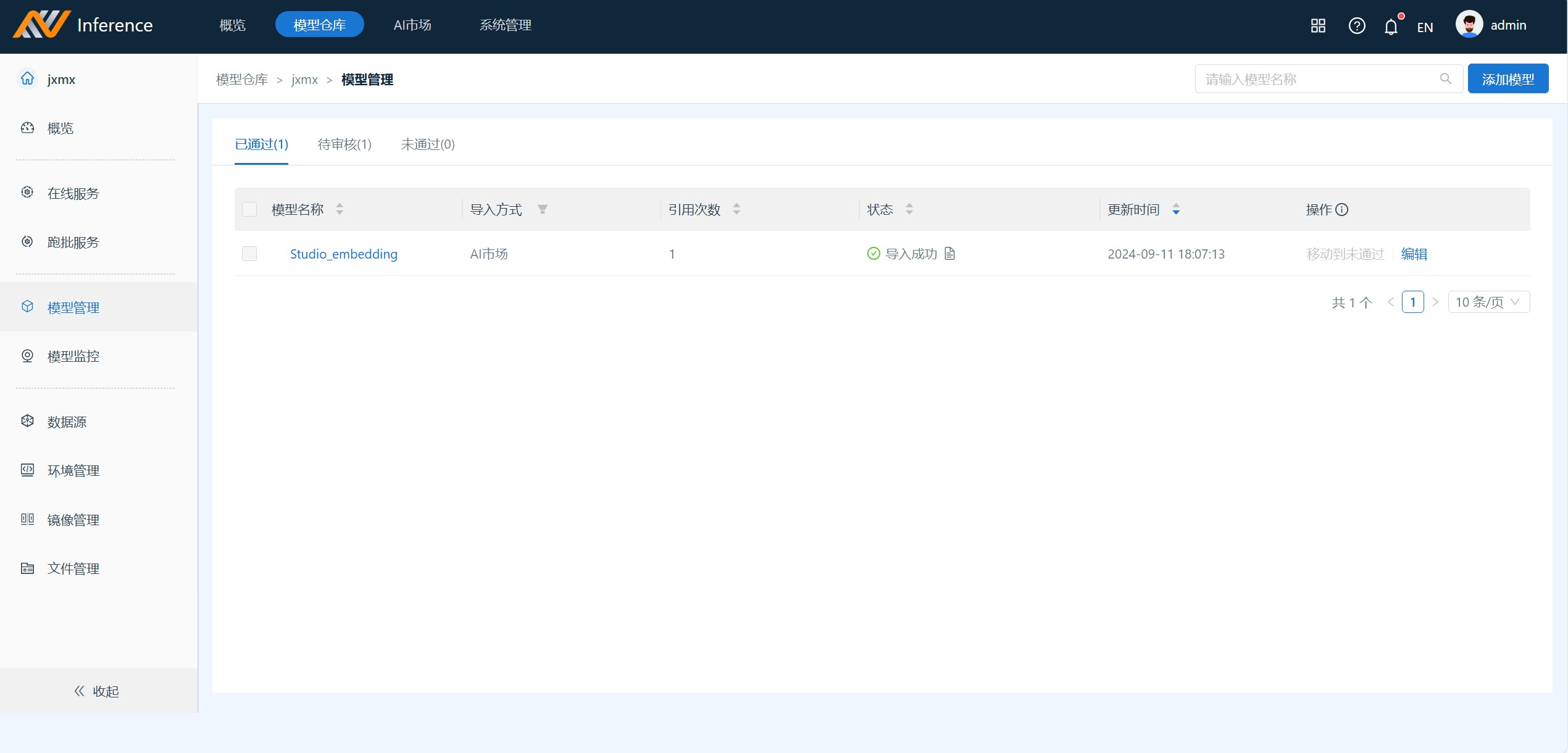

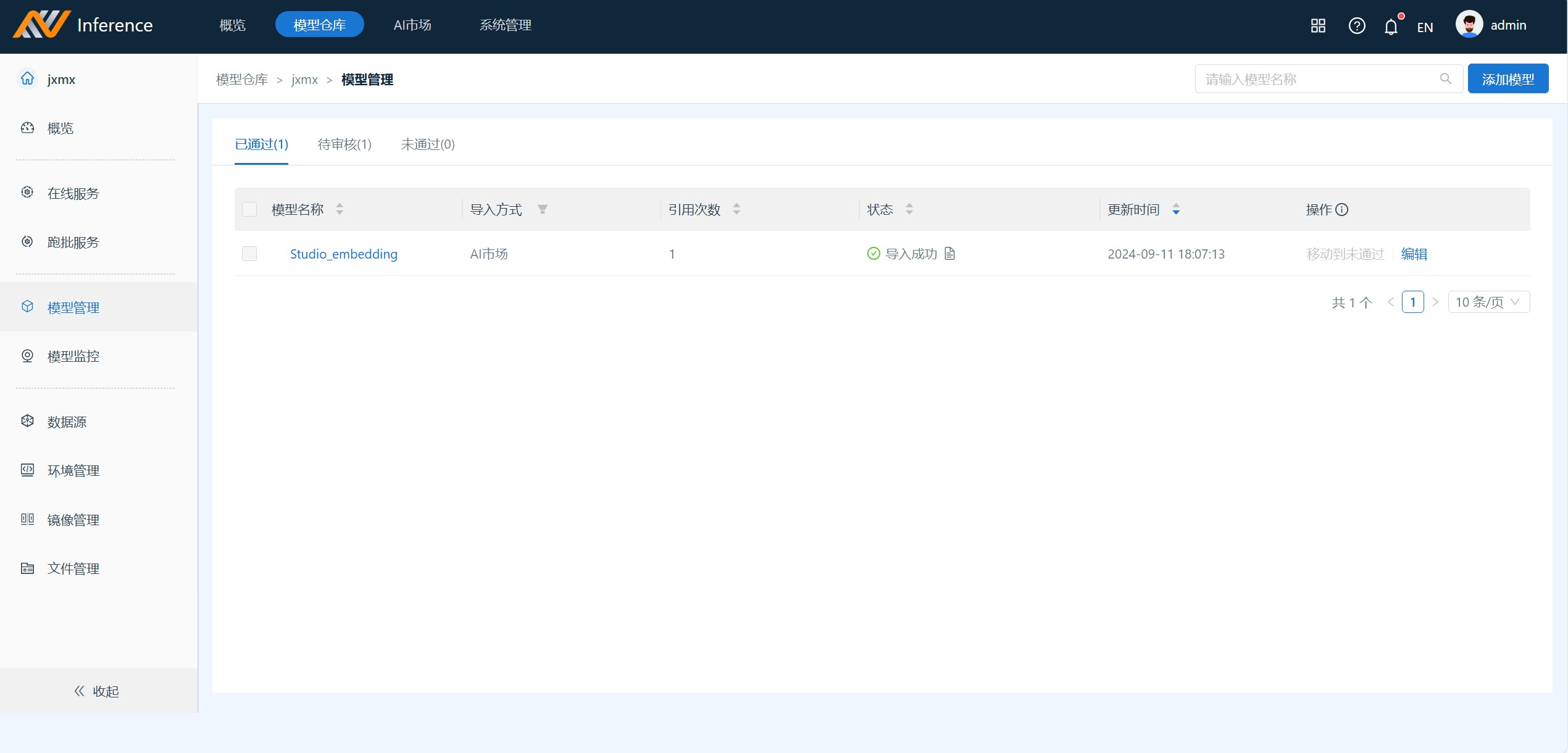

4.选择其中的一个(这里我们选择向量化模型:Studio_embedding),点击下一步,填写相应的模型名称和简介。点击确定

5.添加模型完毕之后,然后点击右侧的在线服务,进入在线服务界面,点击新建部署,选在刚才在模型管理配置的模型;模型部署完毕后,选择选择模型上线

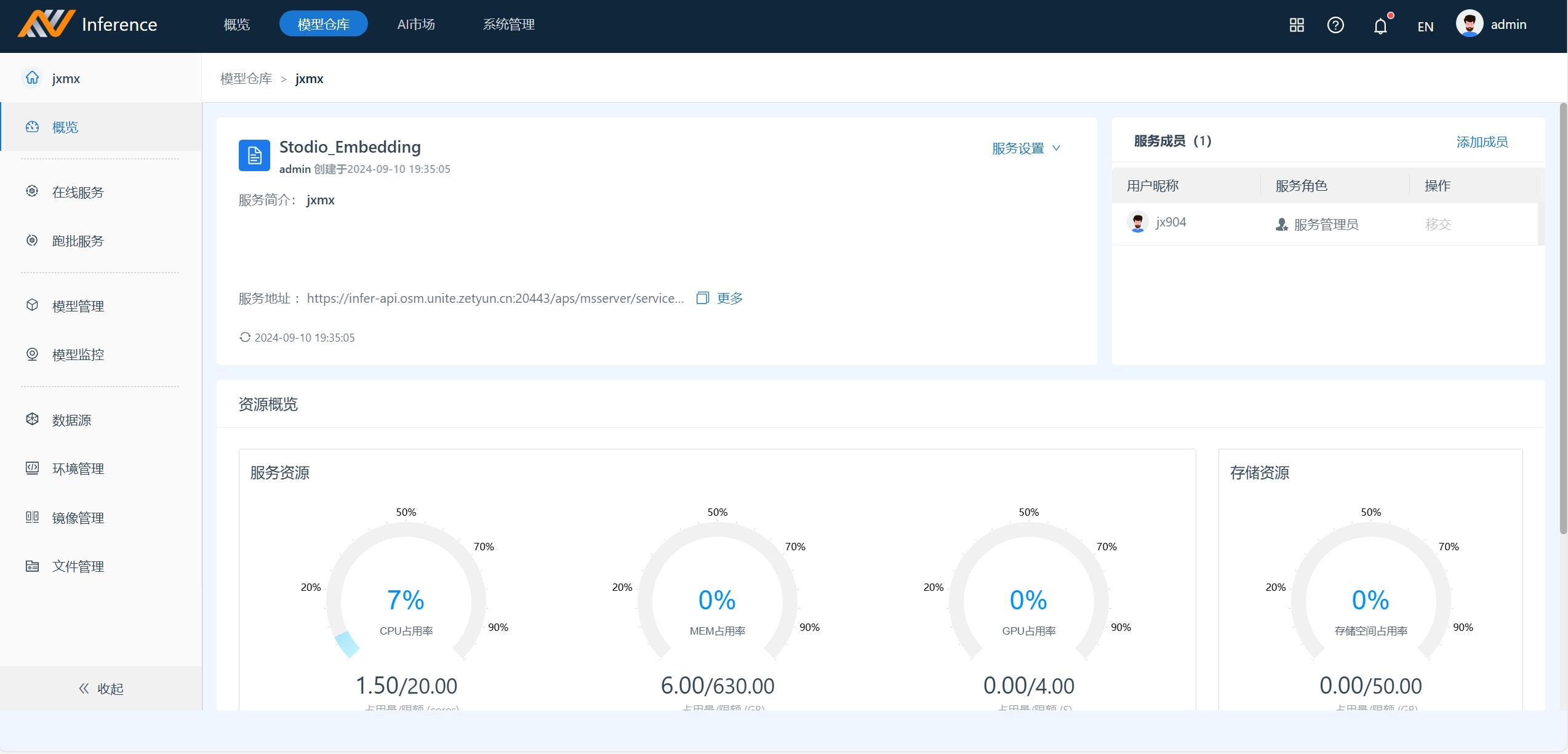

6.模型上线成功后,进入概览界面复制服务地址

Alaya Studio配置镜像模型服务

1.通过Alaya NeW 的进入到Alaya Studio系统,进入模型中心 点击新建,选择向量化模型(在Inference中部署向量量化模型)

名称model为必填,然后模型来源选在 “inference”, 可以看到 base_url后面自动填写model/embed_documents,我们将达前面在Inference中服务地址复制到base_url 的前半段。AccessToken为用户自己创建的。

完成所有必填项的填写后,点击Test按钮进行测试。测试成功后,请点击页面右上角的保存按钮;

随后,在模型中心可以看到新创建的模型。新建模型可在控制台进行调试,并且可以使用该模型对外提供API服务。

部署其他镜像模型

以上为部署的Embedding的镜像模型的步骤,Alaya Studio中还需要部署其他镜像模型:

在Alaya Studio中语音转文本、文本转语音对应了Inference镜像模型的:Studio-Doc-Parser ;

视觉大模型对应了Inference镜像模型的:Studio-Qwen-VL-chat,

文档解析对应Inference镜像模型的:Studio-Audio.