私有化部署满血Deepseek3.2模型

DeepSeek-V3.2-Exp,基于 V3.1-Terminus 升级,采用创新 DeepSeek Sparse Attention 架构,通过动态分配计算资源减少冗余计算,在保持精度的同时显著降低内存占用与计算成本,优化长文本处理效率。

本文详细介绍如何使用云容器实例全流程部署 DeepSeek-V3.2-Exp,展示 DeepSeek-V3.2-Exp 私有化部署的最佳实践。我们旨在提供一个灵活、可扩展且高性能的解决方案,以支持深度学习模型的高效部署与运行。这一方法不仅提升了模型推理的效率,还确保了在私有化环境下的稳定性和安全性。

当前的云容器实例(CCI)仅在【北京三区】支持 DeepSeek-V3.2-Exp 的私有化部署。

前提条件

部署模型

-

登录控制台,单击“产品 > 计算 > 云容器实例”,进入云容器实例页面。

-

单击“云容器管理”,进入云容器实例列表页面,然后在页面右上方选择已创建云容器实例的“智算中心【北京三区】”。

-

单击“去开通”,创建云容器实例。配置相关参数信息,参数详情可参考开通云容器实例的配置参数内容,其中“资源配置”选择默认资源,选择目标应用镜像(如图①),然后单击“立即开通”,开通云容器。

-

开通成功后进入云容器实例页面,在容器列表页面,单击右侧的web连接图标。

-

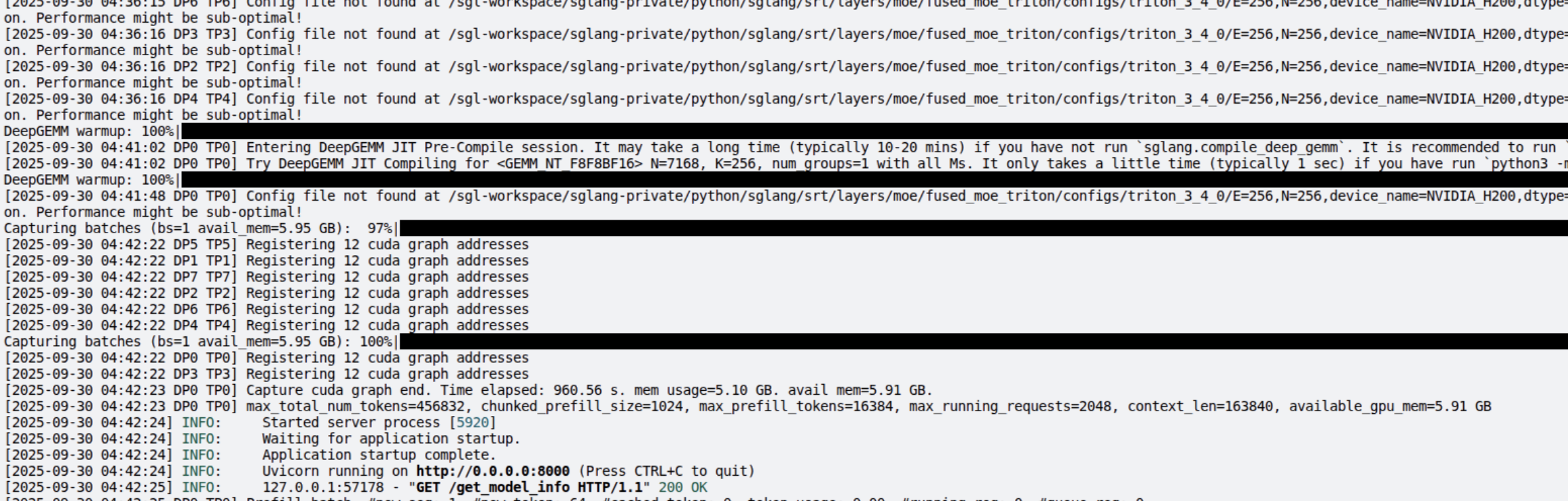

进入 web 连接后,执行如下命令:

##启动大模命令

cd /

export SGLANG_SERVER_HOST=0.0.0.0

export SGLANG_SERVER_PORT=9001

export SGLANG_MODEL_PATH=/root/public/DeepSeek-V3___2-Exp

export SGLANG_MODEL_NAME=deepseek-v32-exp

export SGLANG_TENSOR_PARALLEL_SIZE=8

export SGLANG_API_KEY=sk-12345

chmod +x /start-llm-inference.sh

sh -c /start-llm-inference.sh ##此步骤建议后台进行运行

模型使用

方案一:浏览器直接访问

-

进入云容器实例 Web SSH,执行如下命令,启动 Chat WebUI。

##启动webui应用

export OPENAI_BASE_URL=${OPENAI_BASE_URL:-http://183.166.183.174:9001/v1} ###容器内的模型端口

export OPENAI_API_KEY=${OPENAI_API_KEY:-sk-12345}

export OPENAI_MODEL=${OPENAI_MODEL:-deepseek-v32-exp}

export WEBUI_SERVER_HOST="0.0.0.0"

export WEBUI_SERVER_PORT=9002

chmod +x /start-chat-webui.sh

sh -c /start-chat-webui.sh -

返回云容器实例列表页面,单击开放端口图标。

-

复制开放端口的 9002 的地址。

-

在浏览器中输入地址直接进行访问,进入界面直接与 Deepseek3.2 模型进行对话。

方案二:调用接口方案

-

再次进入云容器实例列表页面,单击开放端口图标,复制 9001 的地址,用户在终端管理页面可使用

curl命令行工具向已部署的服务发送 HTTP 请求,与 Deepseek3.2 模型对话。curl --location --request POST 'http://183.166.183.17*:30010/v1/chat/completions' \

--header 'Authorization: Bearer sk-12345' \

--header 'Content-Type: application/json' \

--header 'Accept: */*' \

--header 'Host: 183.166.183.174:30010' \

--header 'Connection: keep-alive' \

--data-raw '{

"model": "deepseek-v32-exp",

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "写一首诗,主题是湖水"}

]

}'服务响应输出:

{

"id": "3b8a3c290282499f8f076219c4b277ec",

"object": "chat.completion",

"created": 1759250598,

"model": "deepseek-v32-exp",

"choices": [

{

"index": 0,

"message": {

"role": "assistant",

"content": "《湖水》\n\n被风揉皱的绸缎\n是天光跌碎的镜台\n柳枝垂钓着云影\n一圈年轮\n推开一个等待\n\n野鸭划破的寂静\n在芦苇弯腰时重来\n夕阳斜坠的金线\n缝补星辰\n与浪花的对白\n\n晚霞滴落的胭脂\n醉成满湖胭脂的徘徊\n谁在岸边拾起\n一枚月亮\n藏入青苔的胸怀",

"reasoning_content": null,

"tool_calls": null

},

"logprobs": null,

"finish_reason": "stop",

"matched_stop": 1

}

],

"usage": {

"prompt_tokens": 17,

"total_tokens": 114,

"completion_tokens": 97,

"prompt_tokens_details": null,

"reasoning_tokens": 0

},

"metadata": {

"weight_version": "default"

}

} -

除了上述访问方式外,用户还可以通过 Python 代码使用已部署的服务。

import http.client

import json

conn = http.client.HTTPSConnection("183.166.183.17*", 30010)

payload = json.dumps({

"model": "deepseek-v32-exp",

"messages": [

{

"role": "system",

"content": "You are a helpful assistant."

},

{

"role": "user",

"content": "写一首诗,主题是湖水"

}

]

})

headers = {

'Authorization': 'Bearer sk-12345',

'Content-Type': 'application/json',

'Accept': '*/*',

'Host': '183.166.183.174:30010',

'Connection': 'keep-alive'

}

conn.request("POST", "/v1/chat/completions", payload, headers)

res = conn.getresponse()

data = res.read()

print(data.decode("utf-8"))

此外用户也可使用跨平台 AI 客户端工具,例如 AnythingLLM、Chatbox AI、Cherry Studio 等客户端工具,调用已部署的服务。