工作流程

Aladdin(Alaya AI Addin)是由九章云极自主研发的IDE插件,专为大模型开发设计,支持包括VS Code和Cursor在内的多种代码编辑器,用户可通过Aladdin开发工具便捷实现LLaMA Factory的训练、微调。

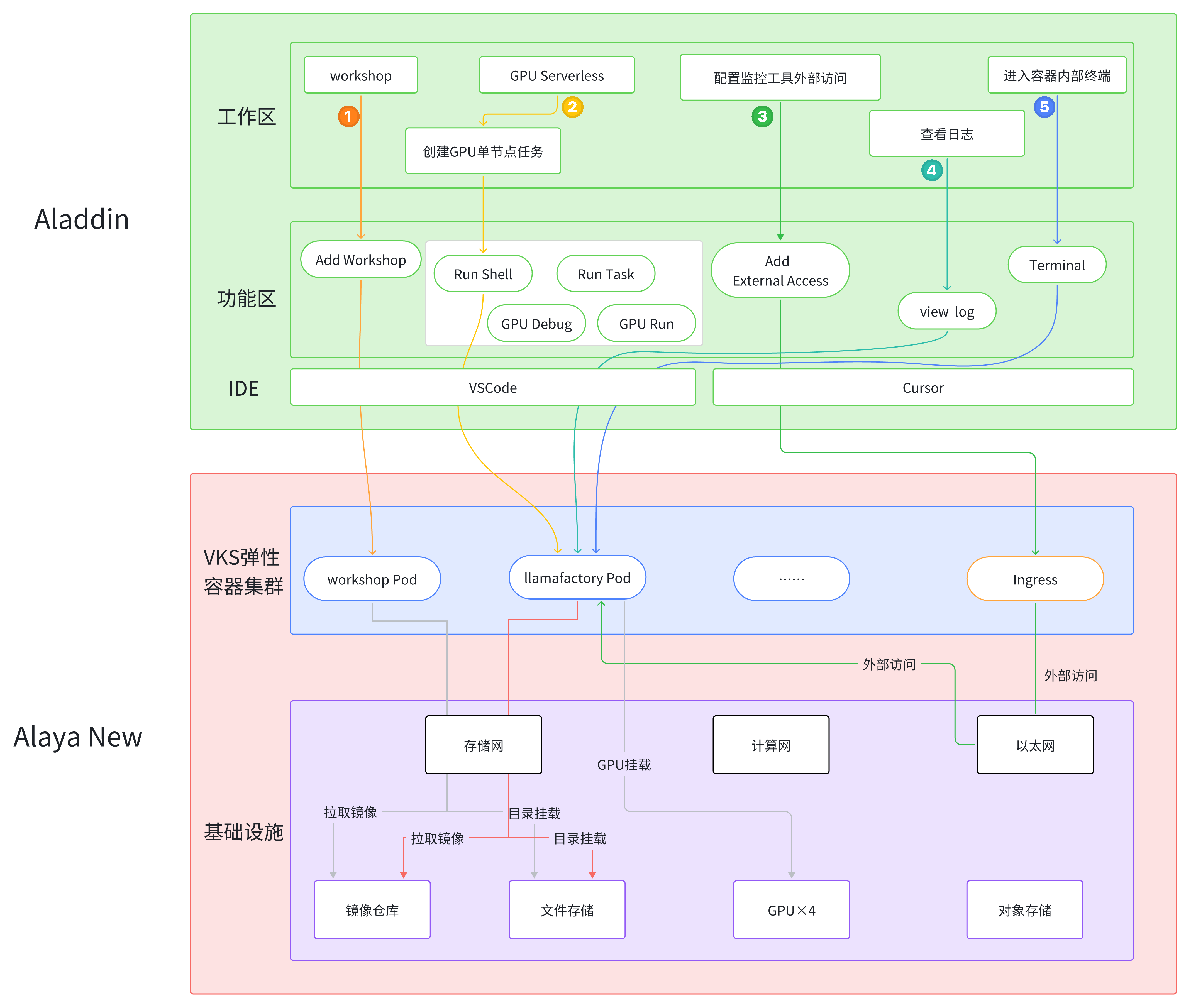

LLaMA Factory支持通过WebUI零代码微调大语言模型,本示例使用单卡进行轻量化调试,结合跨模态统一训练框架,实现了从轻量实验到大规模多模态任务的灵活覆盖,支持文本+图像、文本+音频等多模态输入。

流程图

-

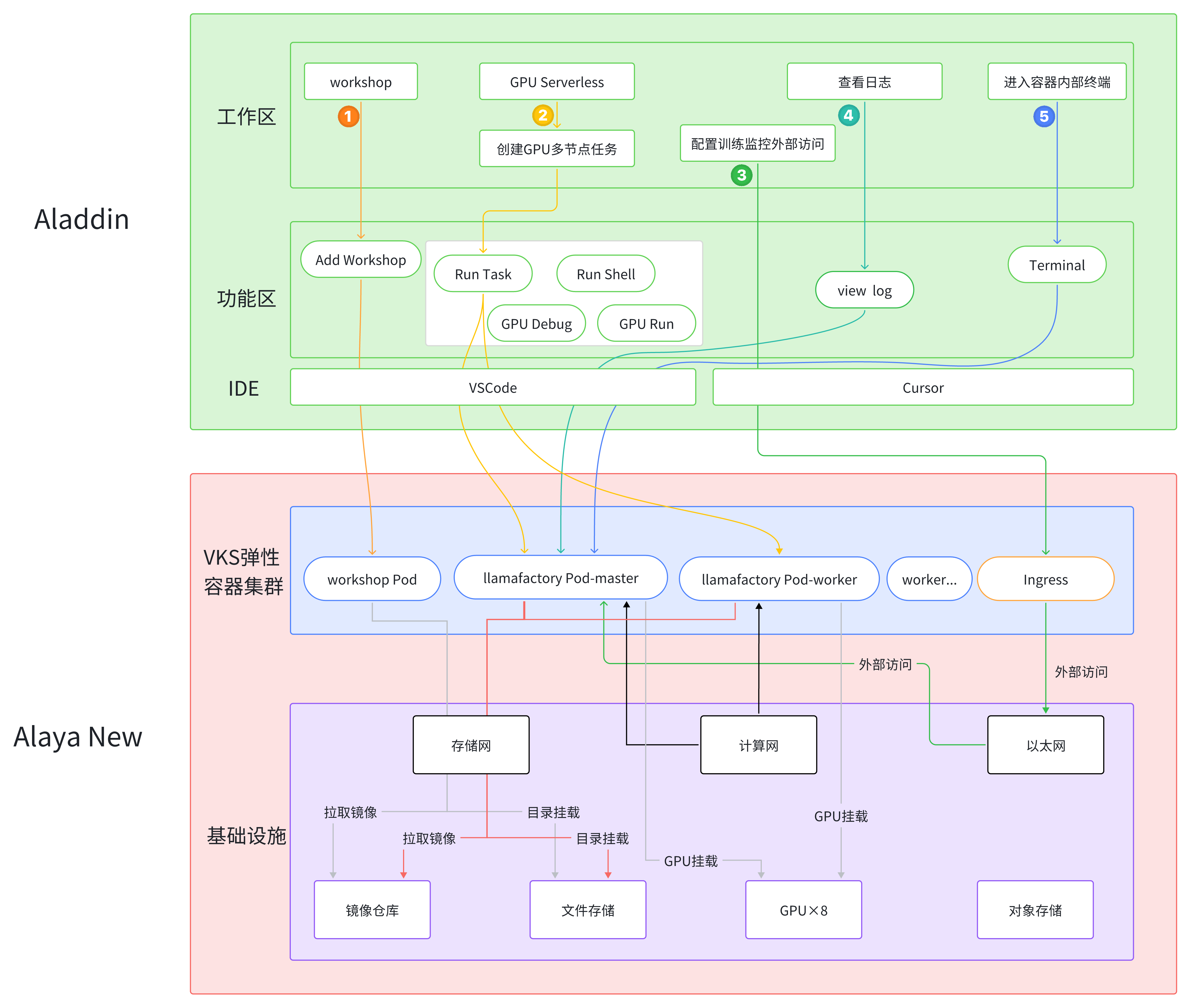

单机多卡通过利用多个计算节点并行处理任务,工作流程图如下所示,具体操作步骤可参考分布训练/单机多卡(DeepSpeed)文章所述。

-

多机多卡通过利用多个计算节点并行处理任务,工作流程图如下所示,具体操作步骤可参考分布训练/多机多卡(DeepSpeed)文章所述。

工作流程说明如下所示。

- 用户在Aladdin工作区中,通过功能区点击“Add Workshop”按钮来创建Workshop。创建成功后,系统将在VKS(弹性容器集群)中对应启动一个Pod,供用户进行开发使用。

- 编写所需的代码及启动脚本后,执行“Run Task”功能。系统将在VKS(弹性容器集群)中启动一个与Workshop环境一致的Pod,系统即可挂载相应的GPU资源以支持高性能计算任务。

- 在工作区配置训练监控工具的外部访问。

- 在微调训练过程中,用户可使用“View Log”功能实时查看相关日志信息,便于监控训练状态和调试问题。

- 用户可通过Terminal进入容器终端,执行各类命令以进行环境检查、服务调试或数据处理等操作。

备注

- 单机多卡仅使用一类Pod,无master和worker类型Pod的区别。

- 单机多卡使用GPU资源为4xH800,多机多卡使用GPU资源为8xH800。

总结

通过Aladdin,用户可以高效地预处理和管理LLaMA Factory所需的各种资源,显著提升训练和微调任务的效率与便捷性。其主要优势包括:

- 一站式数据与模型管理:在Aladdin上,用户能够统一管理和维护LLaMA Factory所需的源码文件、数据集(尤其是大文件)以及大型模型文件等所有必要资源,简化了资源管理流程。

- 快速数据加载与预处理:Aladdin支持用户预处理所需的数据集,并在执行训练或微调任务时快捷加载这些数据,极大缩短了准备时间,提高了工作效率。

- 无缝集成Serverless架构:利用Aladdin提供的Serverless能力,用户可以轻松访问和使用GPU、存储等关键计算资源,无需担心底层基础设施的配置和管理,使得大规模训练和微调任务更加简便。

- 灵活资源配置:根据实际需求动态分配计算资源,如GPU和存储空间,确保资源的最佳利用,减少浪费并降低成本,适合需要频繁调整资源的大规模实验和部署。

- 增强的任务执行能力:无论是简单的实验还是复杂的生产部署,Aladdin都能为LLaMA Factory提供强大的支持,让用户专注于算法优化和模型改进,而非繁琐的资源调度和系统维护。

信息

关于License,请按照LLaMA Factory的版权要求使用,请参考该链接内容。