DeepSeek各模型资源推荐

Alaya NeW算力云简介

信息

Alaya NeW算力服务针对大模型基础设施实现全局加速优化:通过算法加速、编译优化、内存优化、通信加速实现训练效率提升100%、GPU利用率提升50%、推理速度提升4倍,向用户提供开箱即用的高性能模型训练服务、安全的高性能私有模型仓库、动态模型推理服务。

Alaya NeW算力云提供布局全国的智算算力,支持主流高性能加速卡及其算力组合,同时依托其在算力适配、纳管、调度和优化等方面的能力,以及面向大模型任务所提供的专用的调度算法和策略,全面提升了算力服务性能。 通过高度集成的存储技术和创新的系统设计,专为大模型加速优化存储设施,全面支持各类存储协议,在不同类型的应用需求和计算场景下都能实现最佳性能。

凭借高性能的算力服务用户可以轻松实现DeepSeek模型在云端的推理服务部署,并根据实际需求灵活使用算力,为技术创新与科研探索提供高效支持。

一键部署示例

快速上手DeepSeek!不想被复杂的配置流程困扰?别担心!只需三步,帮助用户轻松完成DeepSeek大语言模型的一键部署。

一键部署详情可参看使用指南-弹性容器集群-Aladdin。

各模型的推荐配置

| DeepSeek版本 | 参数规模(B) | 模型大小(约) | 推荐算力配置(至少) | 推荐存储配置(至少) |

|---|---|---|---|---|

| DeepSeek-V3 | 671 | FP8: 671GB | H800*16 | 800GB |

| DeepSeek-R1 1.58 bit量化版 | 671 | FP8:131GB | H800*4 | 200GB |

| DeepSeek-R1 | 671 | FP8:671GB | H800*16 | 800GB |

| DeepSeek-R1-Distill-Qwen-1.5B | 1.5 | BF16: 3.55GB | H800*1 | 50GB |

| DeepSeek-R1-Distill-Qwen-7B | 7 | BF16: 15.23GB | H800*1 | 50GB |

| DeepSeek-R1-Distill-Qwen-8B | 8 | BF16:16.06GB | H800*1 | 50GB |

| DeepSeek-R1-Distill-Qwen-14B | 14 | BF16: 29.54GB | H800*1 | 50GB |

| DeepSeek-R1-Distill-Qwen-32B | 32 | BF16: 65.53GB | H800*1 | 100GB |

| DeepSeek-R1-Distill-Qwen-70B | 70 | BF16: 150GB | H800*2 | 200GB |

提示

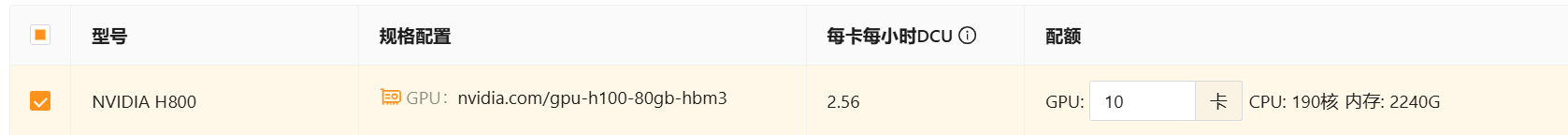

🎉️ 在弹性容器集群配置页面用户可便捷配置所需算力资源,如下图所示。

🎉️在弹性容器集群配置页面用户可便捷配置所需存储资源。

WebUI对话示例

- 下载并安装 ChatBox AI客户端 https://chatboxai.app/zh。

- 点击"设置"添加自定义提供方,在设置中输入模型名称和API域名。

- 输入问题,开启对话,如下文所示。