单机多卡微调(WebUI)

LLaMA Factory单机多卡微调(WebUI)

单机多卡微调聚焦计算效率与扩展性,针对大规模模型训练的需求,本方案通过数据并行、模型并行(包括张量并行和流水线并行)以及ZeRO优化技术,有效突破了单GPU显存限制,支持对百亿级参数模型(如70B+规模)进行高效的多模态微调。此方法特别适用于解决高复杂度、大规模数据集的训练挑战。提示

以下内容仅为视频大纲的简要说明,详细操作步骤及动态演示请参看完整视频,如果需要进一步了解某个步骤,建议结合视频中的讲解和实际操作进行学习。

视频大纲

主要内容包括:

-

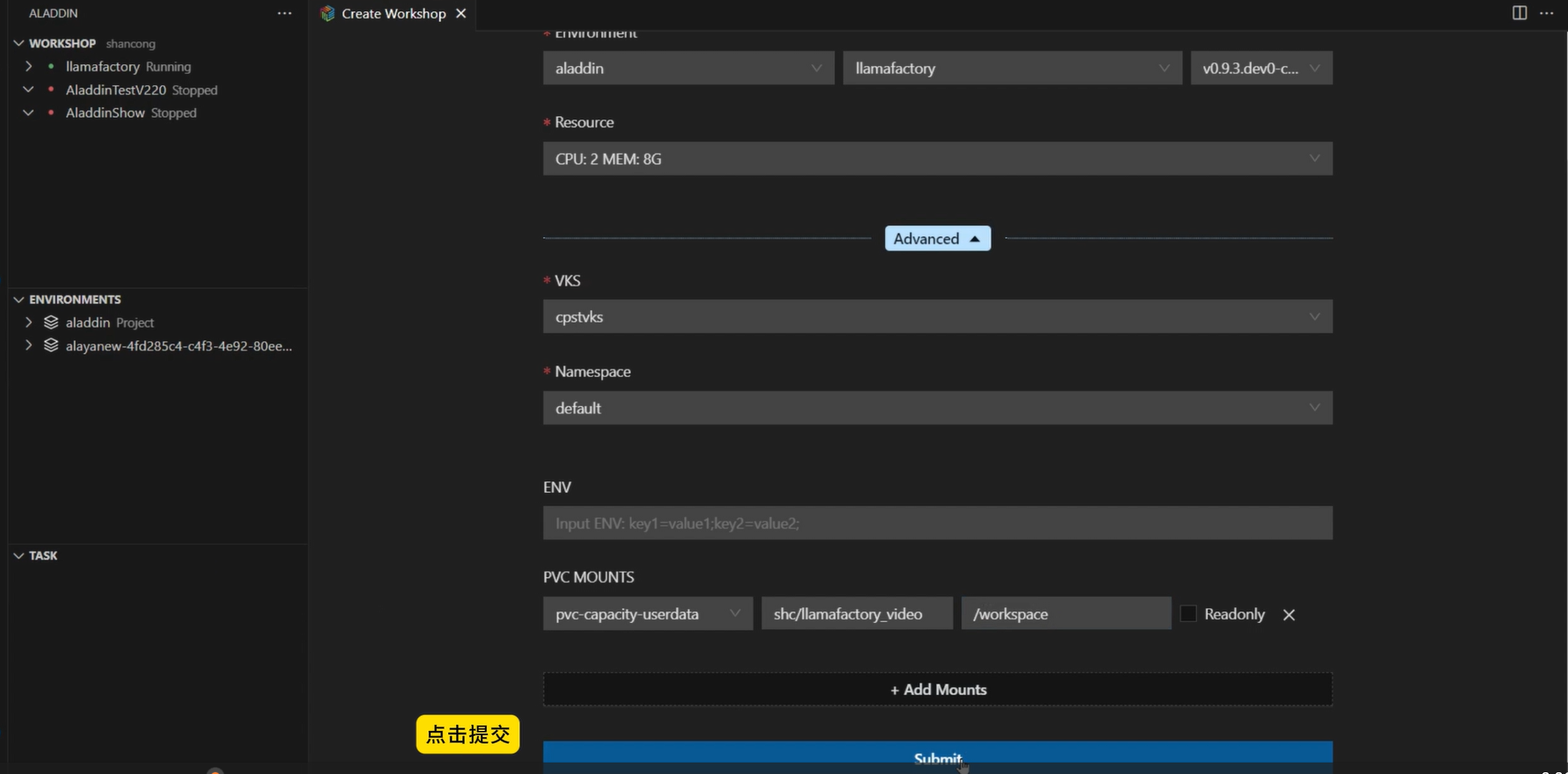

本节视频将演示用户如何在Aladdin平台上创建一个Workshop,选择预置的LLaMA Factory环境,指定已开通的VKS(弹性容器集群),并挂载已配置的PVC存储路径,部分示例页面如下所示。

-

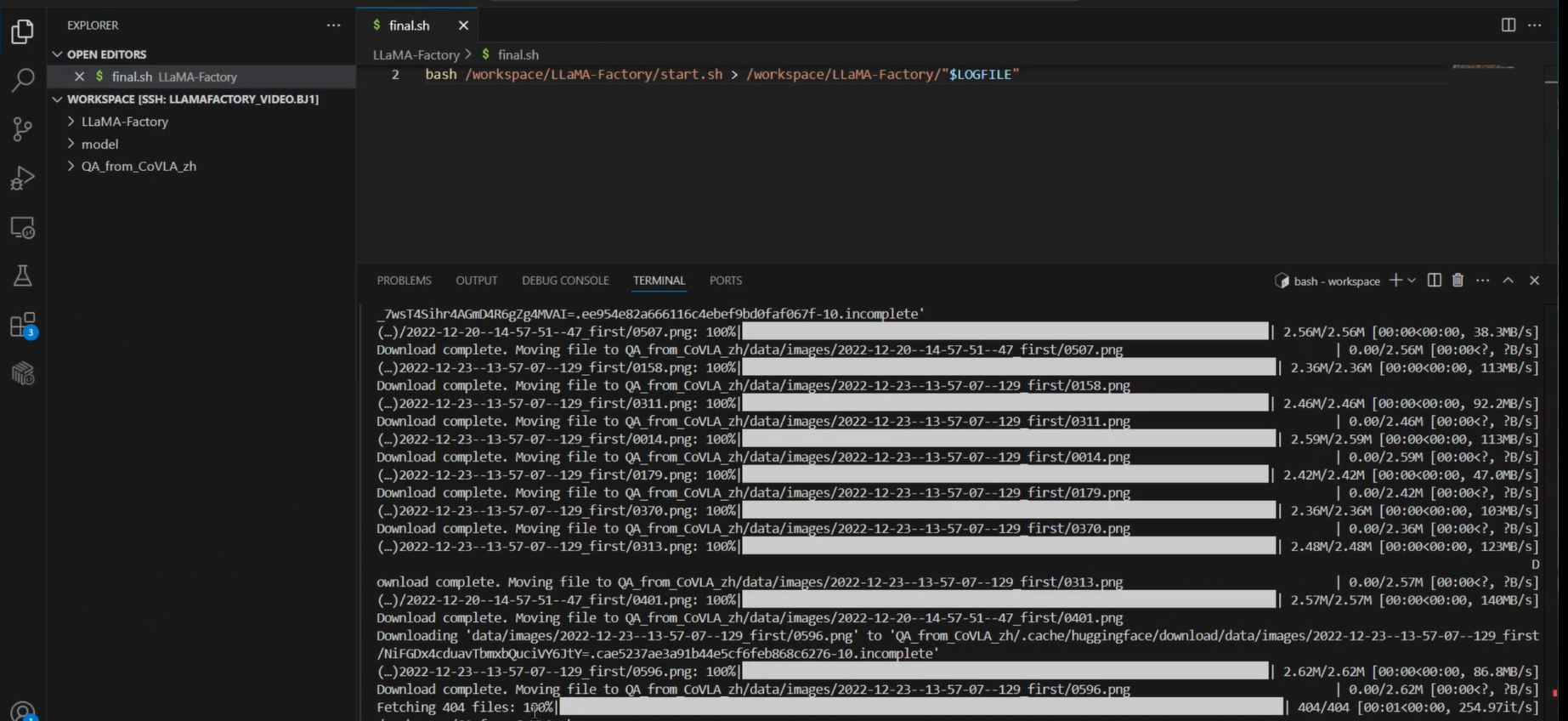

下载模型(Qwen2.5-VL-7B-Instruct),下载微调模型所需的数据集文件(QA_from_CoVLA_zh),将LLaMA Factory源码文件复制到对应的工作路径下,部分示例页面如下所示。

-

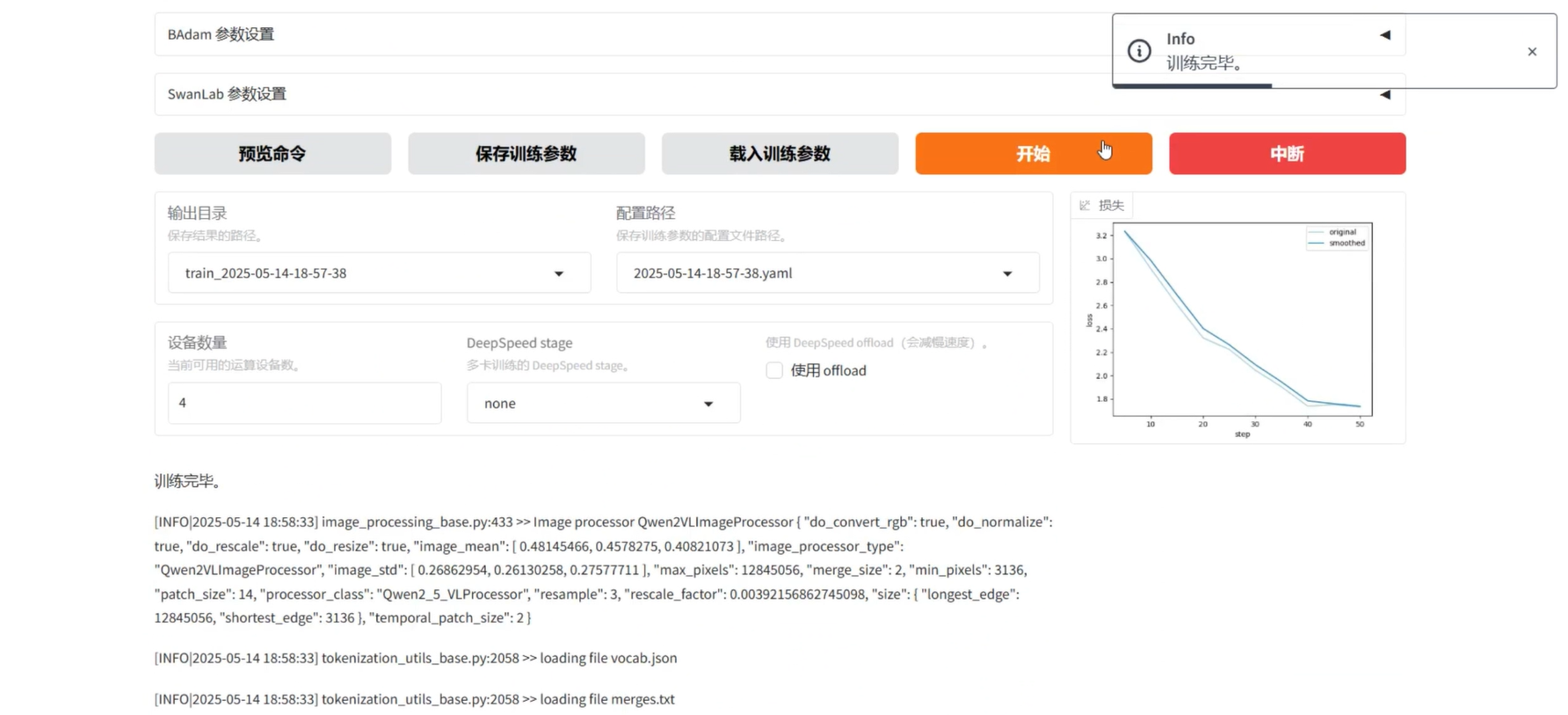

完成准备工作后,在

final.sh文件编辑界面,右键弹窗选择“Run Shell”,配置端口转发等参数,配置完成后,系统自动调用资源启动webUI应用,在WebUI页面选择数据集、模型进行微调,部分示例页面如下所示。