在云容器实例中使用vLLM部署模型

本章节介绍在云容器实例中如何使用 vLLM 镜像,部署并调用平台预置的大语言模型。本文以部署 Baichuan2-7B-chat 模型为例介绍具体的操作过程。

前提条件

- 用户已经获取 Alaya NeW 企业账户和密码,如果需要帮助或尚未注册,可参考注册账户完成注册。

- 当前企业账号的余额充裕,可满足用户使用云容器实例服务的需要。如需了解最新的活动详情及费用信息,请联系我们。

操作步骤

步骤一:创建云容器实例

-

使用已注册的企业账号登录 Alaya NeW 平台,单击[产品/计算/云容器实例]菜单项,进入云容器实例页面。

-

单击“新建云容器”,进入[云容器实例]开通页面,配置实例名称,实例描述,智算中心等参数。 本示例中按如下要求配置各项参数。其中:

-

资源类型:选择“云容器实例-GPU-H800A-1卡”即可。 -

其他参数配置请参考下表进行设置。

配置参数 参数说明 配置要求 是否必须 实例名称 指定云容器的标识符,用于在系统中唯一识别该云容器。 字母开头,支持字母、数字、连字符(-)、下划线(_),长度应为4-20字符。 是 实例描述 云容器的功能、用途、配置等信息进行简要说明的文字描述。 无。 否 智算中心 用于支持云容器实例服务的数据中心。 选择可用的数据中心,例如:北京三区、北京五区等。 是 付费方式 使用数据中心资源的计费方式。 选择系统目前支持的计费方式,当前为按量计费。 是 资源配置 详细列出算力中心的资源规格,包括资源类型、GPU型号、计算资源规格、磁盘配置等。 选择满足所需的资源。 是 存储配置 可以选择云容器实例中的挂载NAS型存储。 选择需要挂载NAS型存储。 否 镜像 支持公共镜像(包括基础镜像和应用镜像)和私有镜像,可根据需要选择镜像类型。 - 是 其他配置 支持配置环境变量的建和值,同时支持开启云容器实例的自动关机和自动释放。 - 否

-

-

云容器实例参数配置完成后,单击“立即开通”按钮,然后在弹出的对话框中确认已配置的参数,确认无误后单击“确定”,即可完成云容器实例开通操作。

您可以在[计算/云容器实例]页面查看已创建的云容器实例,当云容器实例状态为“运行中”时,表示云容器实例创建成功且可正常使用。

步骤二:模型部署

-

在“云容器实例”页面的“容器列表”页签找到目标云容器实例,单击右侧的web连接图标。

-

执行如下命令,下载 vLLM。

pip install vllm -

执行如下命令,下载模型。

pip install modelscope

##命令行下载

modelscope download --model baichuan-inc/Baichuan2-7B-Chat --local_dir '/root/model/' -

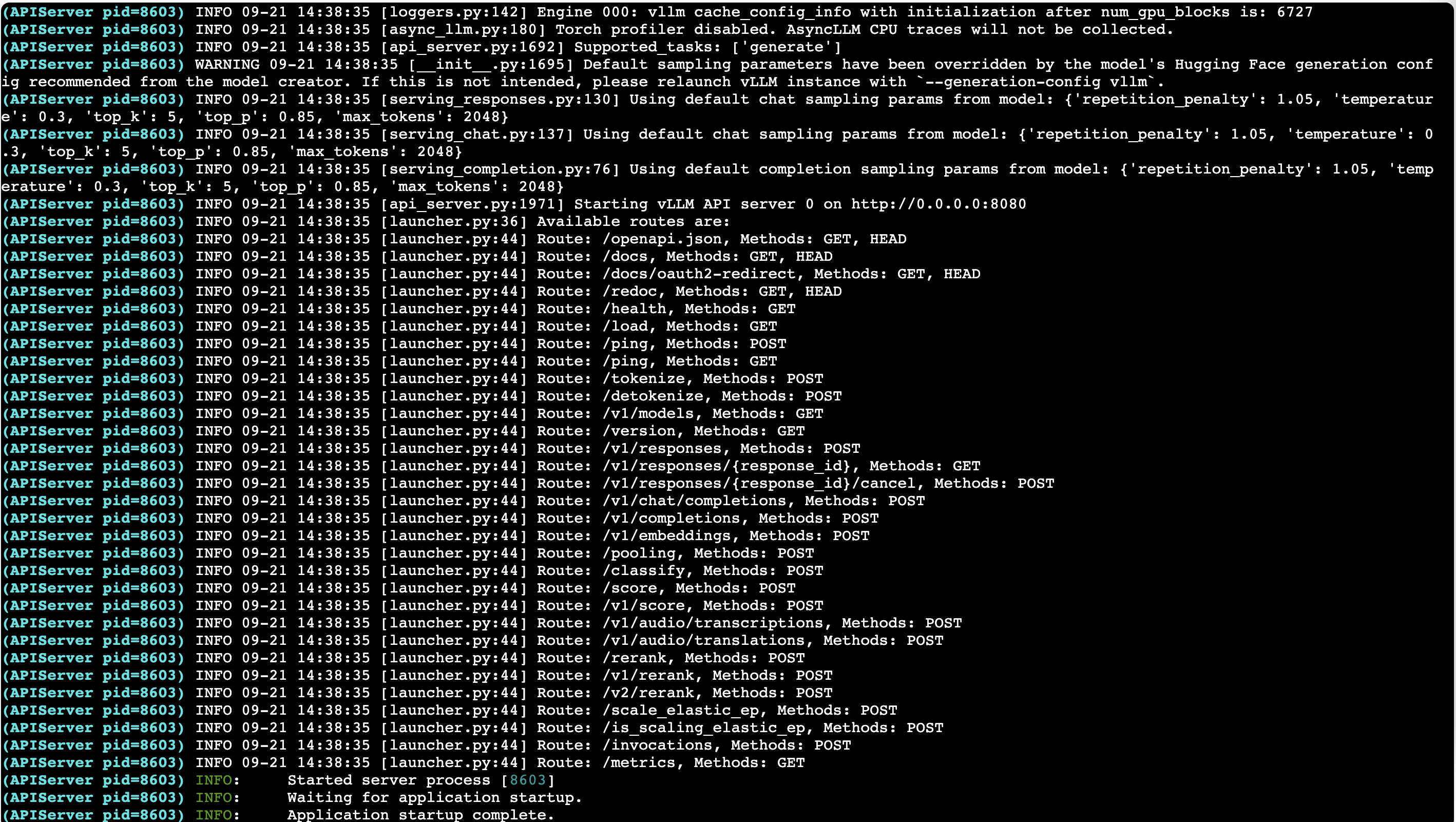

执行如下命令,启动模型推理,并开启模型推理服务。

python3 -m vllm.entrypoints.openai.api_server \

--model /root/model/ \

--host 0.0.0.0 \

--port 8080 \

--dtype auto \

--trust-remote-code注意--model用于指定模型所在路径,需根据上一步下载模型的位置进行修改。回显如下信息,则说明模型推理服务启动成功。

-

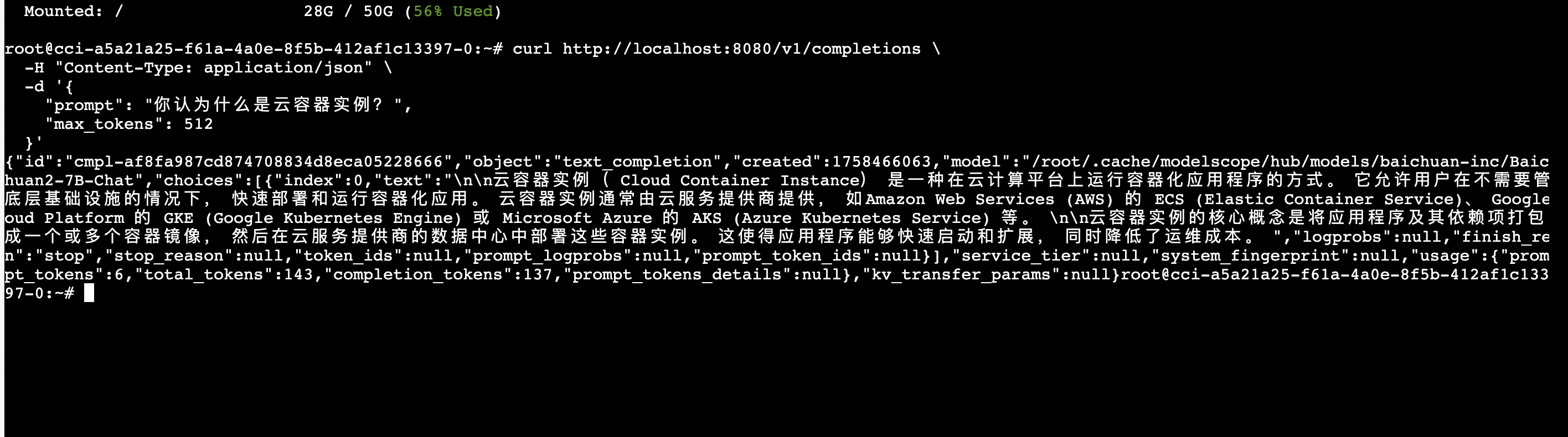

您可重新开启 Web连接,执行如下命令,调用模型。

curl http://localhost:8080/v1/completions \

-H "Content-Type: application/json" \

-d '{

"prompt": "你认为什么是云容器实例?",

"max_tokens": 512

}'