管理在线服务

针对大模型的在线服务,平台提供了服务监控以及服务版本管理能力,并通过在线服务对外提供算法模型的推理能力。

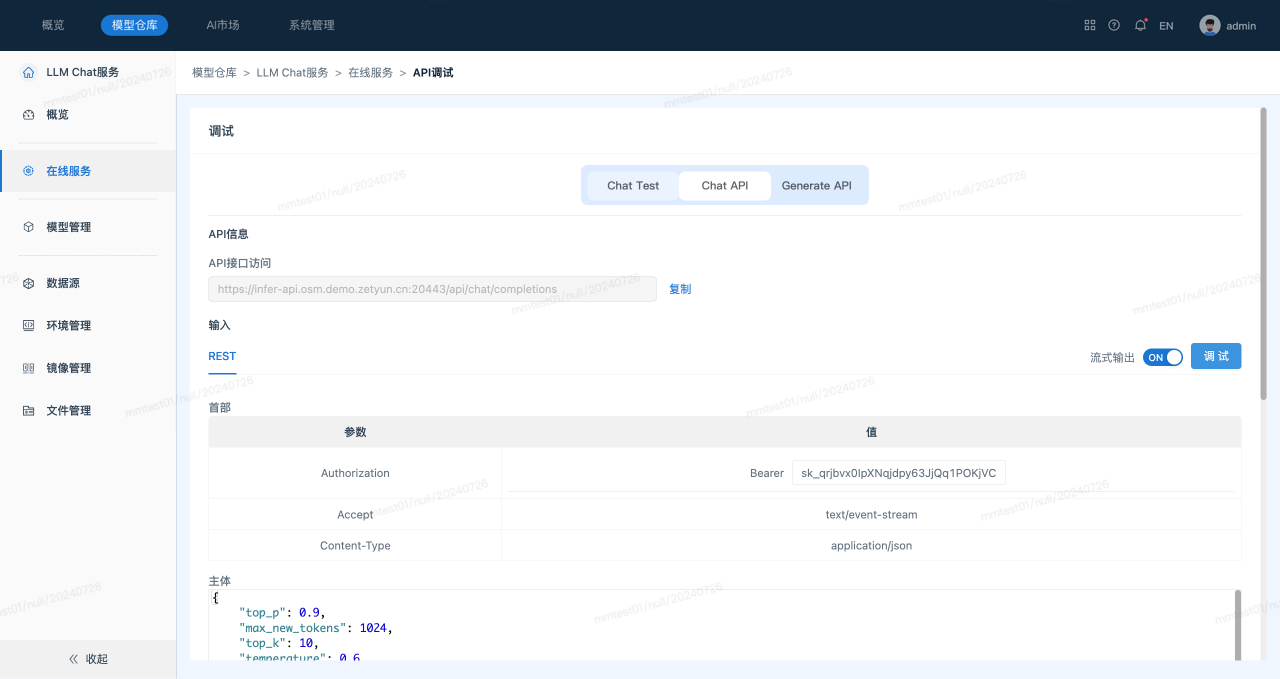

- 根据不同的应用场景,选择合适的调试方法可以提高调试效率和效果:

- Chat Test:通过用户界面(UI)直接与聊天模型进行交互,适合用于手动测试和体验模型的对话效果。

- Chat API:通过编程接口与聊天模型进行交互,适合用于自动化测试和大规模应用场景。

- Generate API:通常用于生成文本内容,适用于生成文章、摘要、编程代码等。

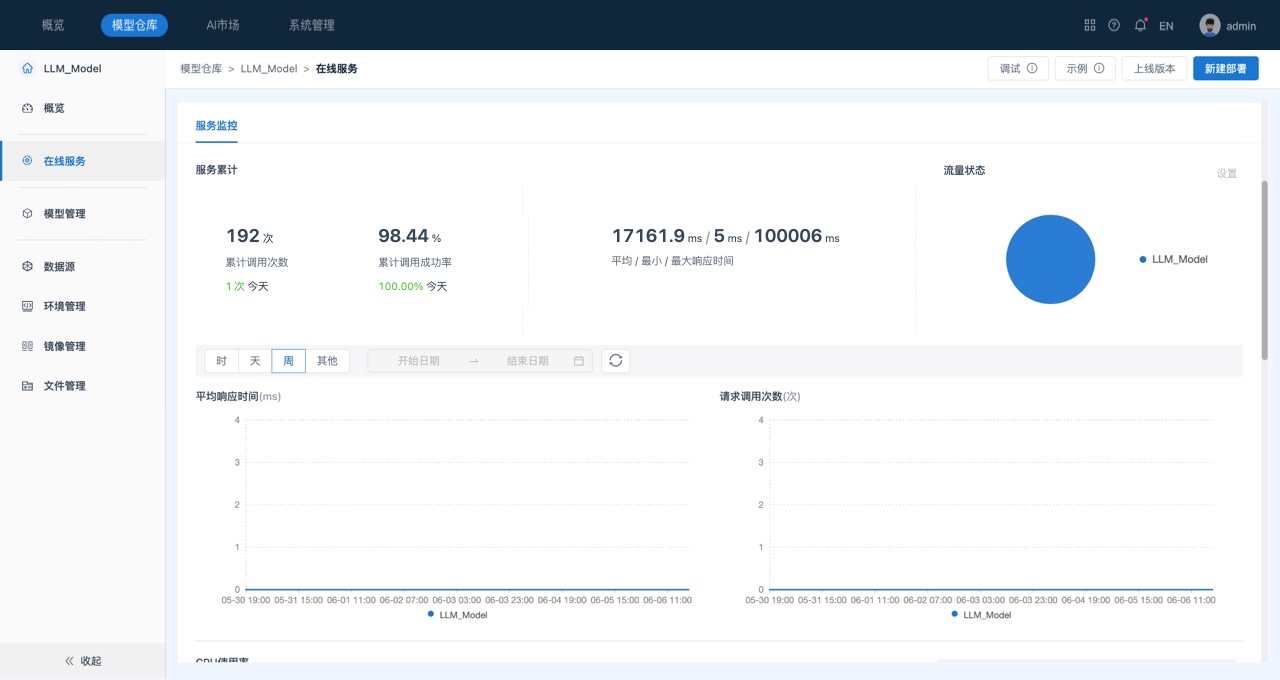

- 为保障服务的稳定运行,系统提供了服务监控功能:

- 容器级监控:平台通过容器为模型提供运行时环境,容器的资源利用率是否合理是监控服务健康持续运行的重要指标。

- 服务级监控:服务调用成功率、响应时长等参数,是监控服务状态的重要指标。

- 通过上线版本记录了服务中模型的变更情况:

- 当对服务中的模型执行上下线操作时,会生成新的服务版本。

- 系统支持版本回滚,但若历史版本中的模型已被删除,则不可再回滚至该版本。

场景描述

管理“LLM Chat服务”服务中的上线模型。

前提条件

- 服务“LLM Chat服务”中的模型已部署成功且上线。

操作步骤

- 在“模型仓库”主界面,选择服务“LLM Chat服务”,进入该服务主页面。

- 在页面左侧的“侧边栏”区域,选择在线服务,系统跳转到“在线服务”列表页面。

- 在“在线服务”列表页面中查看服务监控情况,如下所示:

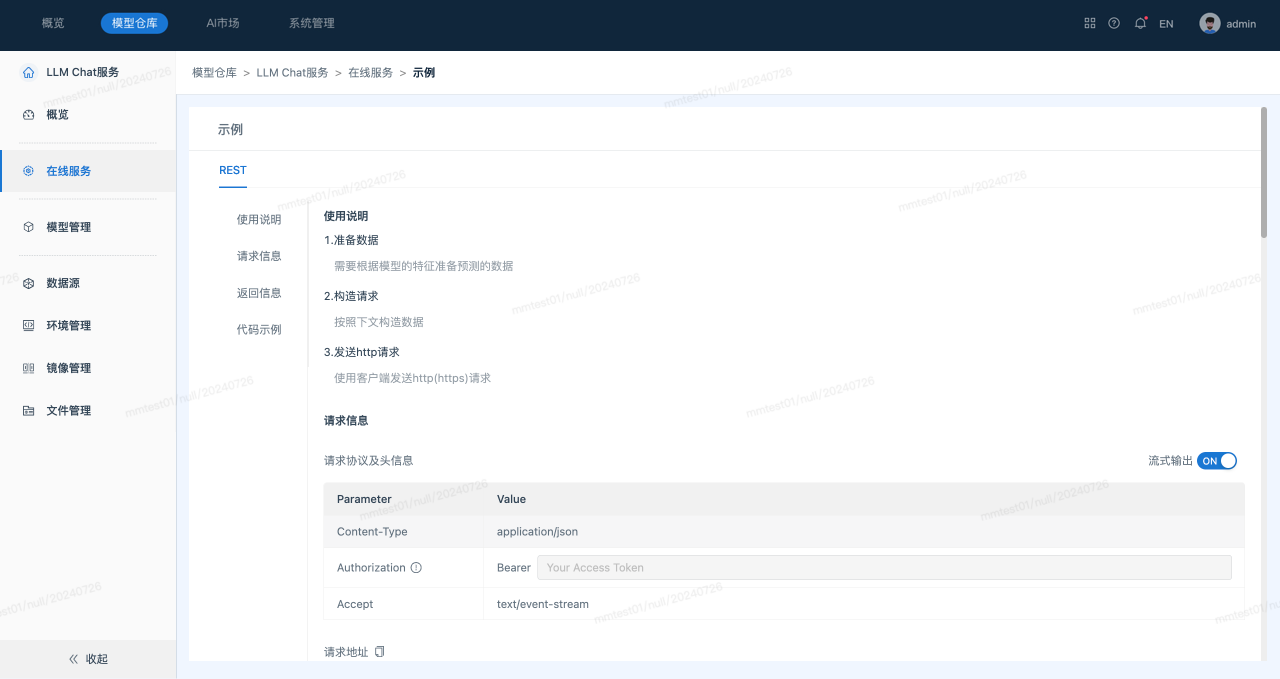

- 查看服务调用示例。

单击页面右上角的服务示例, 系统跳转到“示例”页面,如下所示:

- 调试服务。

a. 单击页面右上角的服务调试, 系统跳转到“调试”页面,切换“Chat Test”、“Chat API”、“Generate API”页签,可以查看不同调试方式,如下所示:

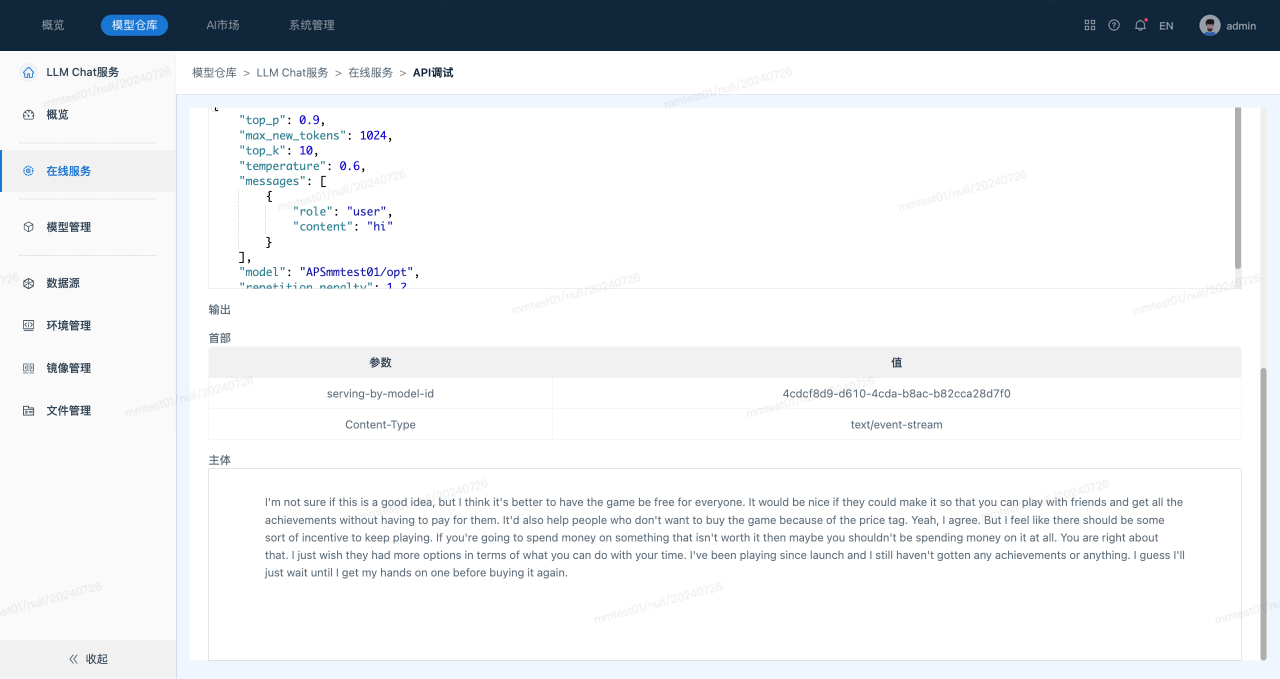

在“Chat API”、“Generate API”的“调试”区域中,系统自动生成了请求数据,用户也可以修改其中各特征的值。

b. 填入访问令牌后,单击调试,可以在运行结果区域可以查看推测结果。